Un test AB sans contrôle, c’est comme tenter de lire une carte sans boussole : une aventure risquée où l’on se félicite parfois d’avoir trouvé le nord… alors qu’on tourne en rond. Des budgets entiers partent en fumée pour valider ce que l’on croit être une avancée, alors qu’il ne s’agit que d’un mirage statistique. Pourtant, dans cette course à la nouveauté, le contrôle, discret mais fondamental, détient la clé de la crédibilité.

Comment une étape si peu spectaculaire peut-elle transformer une simple intuition en moteur de croissance tangible ? Derrière les colonnes de chiffres, un contrôle soigneusement choisi donne le cap à toute stratégie digitale ambitieuse. Le négliger, c’est naviguer à vue et risquer la sortie de route.

Le contrôle dans les tests AB : un pilier souvent sous-estimé

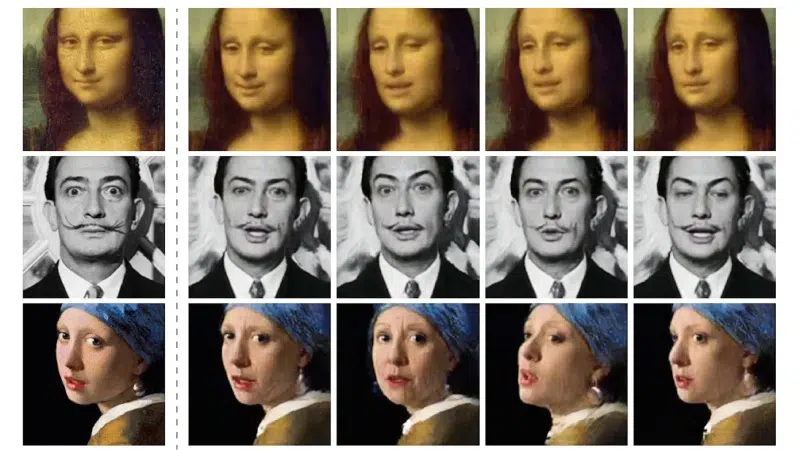

Au cœur du tumulte du testing, la version de contrôle joue un rôle de chef d’orchestre, souvent reléguée dans l’ombre par la fascination de la nouveauté. Le contrôle dans les tests AB, c’est la référence, le socle sur lequel s’appuient toutes les comparaisons. Dans l’univers de l’A/B testing, il s’agit de la version A, ce point d’ancrage indispensable pour mesurer l’effet de la variante, la fameuse version B. Sans ce repère, pas moyen d’évaluer, pas d’évolution solide.

Les méthodes se diversifient :

- Test A/A : deux versions identiques s’affrontent, afin de vérifier la fiabilité de la plateforme de split testing.

- Test multivarié (MVT) : plusieurs éléments changent simultanément, mais chaque combinaison conserve son contrôle.

- Test multi-pages : ici, c’est tout un parcours utilisateur qui est examiné, et le contrôle s’étend alors à chaque étape.

- Test par redirection ou Test bandit : ces variantes sophistiquées dépendent aussi d’un contrôle fiable pour garantir des résultats statistiquement valables.

Le split url testing, quant à lui, permet d’analyser l’impact de chaque version sur des pages distinctes, tout en conservant le même groupe témoin. Dans le domaine marketing, la justesse du contrôle conditionne l’interprétation des résultats et la pertinence des optimisations à venir. C’est le socle d’une prise de décision solide, débarrassée des pièges méthodologiques.

Pourquoi le groupe témoin change la donne dans vos analyses ?

Un test AB repose sur une logique limpide : l’audience est répartie aléatoirement entre le groupe témoin (ou contrôle) et le groupe test. Ce n’est pas un simple détail de protocole. C’est la garantie que chaque utilisateur – qu’il habite Paris ou Lille – a la même probabilité de livrer ses réactions à chaque version.

La taille de l’échantillon : voilà un facteur qui pèse lourd. Si le groupe témoin est trop mince, la comparaison vacille, le hasard fait la loi. À l’inverse, calibrer son audience, c’est obtenir des données nettes, loin des biais d’interprétation.

- La définition de l’objectif précède toute expérimentation : booster le taux de clics, fluidifier l’expérience mobile, affiner une stratégie marketing…

- La formulation de l’hypothèse vient structurer le test : « ce nouveau bouton va doper la conversion ».

Le groupe témoin devient alors la jauge qui valide – ou non – ces hypothèses. Il incarne la rigueur scientifique appliquée au marketing digital. Segmenter l’audience (par canal, région, moment de la journée) ouvre la porte à des analyses pointues, adaptées à chaque cible.

Sans groupe témoin, toute décision flotte dans le vide. Les chiffres perdent leur sens, et l’optimisation de la stratégie digitale devient une loterie.

Comprendre l’impact du contrôle sur la fiabilité de vos résultats

La version de contrôle s’impose dans le test AB comme l’étalon-or. C’est elle qui permet de distinguer l’effet réel d’une variante d’une simple variation de trafic. Les métriques – taux de conversion, taux de clic, taux d’ouverture, taux de rebond – n’ont de poids qu’en rapport avec ce témoin.

La fiabilité repose sur une collecte de données sans faille. Deux grandes écoles : la méthode fréquentiste, qui juge la validité statistique une fois le test terminé, et la méthode bayésienne, qui ajuste l’analyse en continu. Le choix dépendra du contexte et des moyens analytiques à disposition.

- La durée du test doit englober un cycle d’activité complet : semaine, mois, selon la saisonnalité de votre trafic.

- La segmentation par type d’audience (mobile, desktop, nouveaux visiteurs) affine l’analyse.

La signification statistique n’est pas un simple détail : seul un écart significatif entre contrôle et variante justifie l’action. Les outils de web analytics, qu’il s’agisse de Google Analytics ou de solutions spécialisées, accompagnent cette quête de précision à chaque étape du parcours utilisateur.

C’est la robustesse du contrôle qui transforme les tests AB en leviers d’optimisation fondés sur la donnée, et non sur l’intuition. Confrontez, analysez, tranchez : le contrôle forge la légitimité de vos décisions.

Mettre en place un contrôle efficace : bonnes pratiques et erreurs à éviter

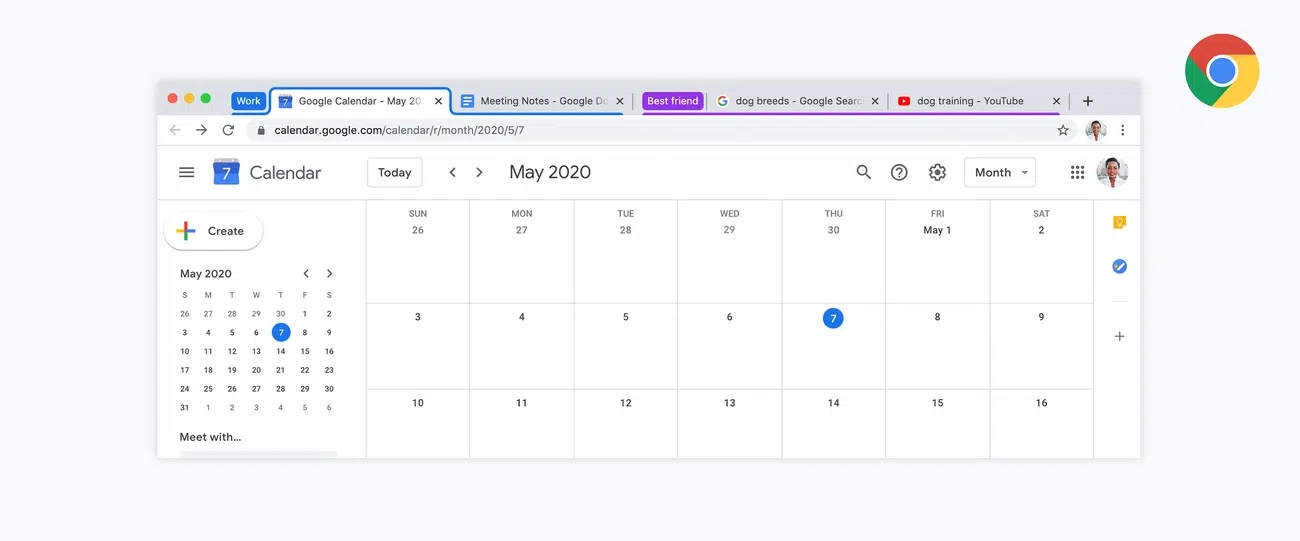

Optez pour une plateforme d’A/B testing éprouvée. Google Optimize, Optimizely, AB Tasty : ces outils offrent un terrain de jeu sécurisé pour orchestrer vos expériences, du split url testing au test multi-pages. L’intégration des web analytics ou l’analyse par heatmaps et session recording enrichit la lecture des résultats. La collaboration entre équipes marketing et techniques, qu’elle soit centralisée, décentralisée ou hybride, fait toute la différence.

Adoptez une méthodologie rigoureuse dès le départ : hypothèses claires, KPI définis, segment d’audience précis. Répartissez les visiteurs de façon aléatoire : c’est la seule façon de comparer honnêtement la version de contrôle et les variantes. Modifier le test en cours de route ? C’est le meilleur moyen de saboter la validité des résultats.

- Calibrez la taille de chaque groupe : un échantillon trop réduit fausse tout.

- Maintenez la durée du test sur un cycle complet, pour lisser les effets de saisonnalité.

- Consignez chaque étape dans un rapport partagé, sur un tableau de bord accessible à tous les acteurs du projet.

Ne reléguez pas à l’arrière-plan le processus d’optimisation continue : chaque test alimente la stratégie marketing digitale globale et affine l’apprentissage collectif. La transparence dans la data, la rigueur dans le reporting : voilà la base d’une décision éclairée. Préparez-vous à itérer : chaque campagne révèle de nouveaux leviers pour transformer l’expérience utilisateur.

Car au bout du compte, la différence se joue là : entre la foi aveugle dans la nouveauté et la lucidité d’un contrôle qui tient la barre. De quoi transformer chaque test AB en tremplin, et non en piège invisible.