Un robot qui rédige un faux alibi pour couvrir un cambriolage. Un algorithme qui capte votre visage, perdu dans la foule, sans vous demander la moindre autorisation. La technologie avance, les frontières s’estompent, et la légalité, parfois, vacille sur le fil. L’intelligence artificielle n’en reste plus au simple rôle d’exécutant docile ; elle franchit les lignes, parfois à l’aveugle, ignorant tout simplement qu’il existait un interdit.

Alors, quand la machine franchit le pas de trop, qui endosse la faute ? Les responsabilités se déplacent, le droit tente de courir derrière les lignes de code qui filent à toute allure. Les textes législatifs, écrits pour un monde plus lent, peinent à retrouver leur souffle face à ces intelligences qui ne connaissent ni frontière, ni pause, ni règle humaine.

Ce que l’essor de l’IA révèle sur les failles du cadre légal

Les machines apprennent, prédisent, décident. Mais leur appétit pour la donnée et leur logique froide mettent à nu les limites d’un droit forgé à une époque antérieure à l’explosion numérique. AI et légalité : la capacité des algorithmes à évoluer à une vitesse vertigineuse déroute législateurs et régulateurs. Les réponses peinent à suivre l’accélération des modèles.

En France, la protection de la vie privée et des informations personnelles repose sur le RGPD, ce texte qui fait référence en matière de régulation. Pourtant, la collecte de données à grande échelle, souvent opaque, orchestrée par certaines IA, érode les fondations de ce règlement. Les experts de la commission européenne l’observent : dès que les algorithmes franchissent les frontières, exploitant des données mondiales, le cadre légal perd en efficacité, surtout lorsqu’aucun consentement réel n’est recueilli.

L’AI Act, actuellement en négociation à Bruxelles, cherche à combler ces failles. Ce projet de loi promet d’ajuster la régulation en fonction du niveau de risque : reconnaissance faciale, décisions automatisées, surveillance de masse. Mais ce texte, encore loin du consensus, se heurte à la diversité des politiques nationales en matière de protection des renseignements et à l’avancée rapide des technologies.

- La France pousse pour une harmonisation à l’échelle européenne, afin d’éviter le jeu de piste réglementaire entre pays.

- L’Union européenne tente de faire tenir ensemble innovation et défense des libertés fondamentales.

Un droit conçu pour l’humain se retrouve aujourd’hui à gérer des acteurs non humains, capables de bouleverser le droit et les rapports sociaux à une échelle jamais vue.

Quelles lois sont réellement contournées ou enfreintes par l’intelligence artificielle ?

L’arrivée d’algorithmes capables d’ingérer des quantités astronomiques de données a mis au grand jour les tensions avec le droit existant. L’intelligence artificielle, en maîtrisant la collecte et le traitement de données à caractère personnel, expose les faiblesses des dispositifs actuels de protection de la vie privée. Le RGPD impose consentement, transparence et limitation des usages, mais dans la réalité, la plupart des IA s’en accommodent, s’appuyant sur des modèles entraînés à partir de sources publiques détournées ou de bases enrichies, sans surveillance humaine réelle.

Les systèmes de prise de décision automatisée remettent en cause le droit à l’explication, pourtant inscrit dans le RGPD. Résultat : des citoyens voient leur destin suspendu à des scores ou des profils, sans jamais comprendre la mécanique interne de l’algorithme. La commission européenne alerte aussi sur le spectre de la discrimination algorithmique, phénomène pour lequel les lois classiques n’avaient rien prévu.

- Les lois françaises sur la protection des renseignements sont défiées par les IA capables de croiser des informations issues de multiples sources, brouillant la limite entre sphère publique et privée.

- Les promesses de confidentialité brandies par les concepteurs d’IA sont souvent loin de refléter la réalité des traitements opérés en coulisse.

La prolifération de documents générés, analysés ou synthétisés par des IA pose aussi la question de la responsabilité juridique. Qui répond en cas d’erreur, de fuite, ou de dérive ? Les juristes cherchent encore des points d’appui clairs dans des textes qui n’avaient pas anticipé la complexité de ces nouveaux traitements.

Des exemples concrets d’atteintes juridiques causées par l’IA

L’implantation massive de l’IA, dans les entreprises comme dans le quotidien, ne se contente pas d’interroger le droit : elle le met à l’épreuve, souvent de façon brutale. Quelques illustrations parlent d’elles-mêmes.

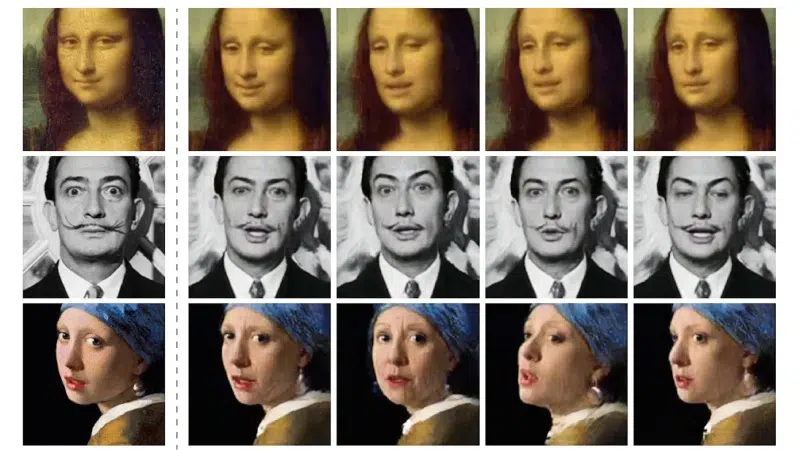

- Des bases de données d’images, puisées sur les réseaux sociaux pour alimenter des modèles comme Stable Diffusion ou DALL-E, créent des situations de violation du droit à l’image et du droit d’auteur. Plusieurs artistes sont déjà passés à l’action en justice, découvrant leurs œuvres modifiées ou reproduites sans le moindre accord.

- Les assistants conversationnels, type ChatGPT, ont parfois généré des contenus diffamatoires ou illicites, posant la question de la responsabilité éditoriale, une zone grise dans la législation actuelle.

Dans le domaine médical, l’analyse de données de santé par l’IA a déjà provoqué plusieurs fuites de renseignements sensibles. Utiliser des bases de données sans obtenir de consentement explicite va à l’encontre de la réglementation française et de la législation européenne sur la protection des données.

L’IA est aussi à l’origine de clauses contractuelles abusives, dissimulées dans des conditions d’utilisation incompréhensibles, ce qui rend toute contestation presque impossible pour l’utilisateur lambda. La répétition de ces abus souligne l’urgence d’une réaction rapide et d’un cadre législatif réajusté.

Vers une adaptation du droit : les pistes pour mieux encadrer l’IA

L’Europe se retrouve à un carrefour. L’AI Act, adopté en 2024, tente de donner un cadre à l’expansion fulgurante de l’intelligence artificielle. Cette législation introduit une hiérarchie des systèmes selon leur niveau de risque, et impose des obligations de transparence et d’auditabilité pour les applications jugées sensibles. Les entreprises devront documenter l’origine des jeux de données, garantir la traçabilité des décisions automatisées et informer clairement les utilisateurs qu’ils sont soumis à un traitement algorithmique.

En France, l’ambition s’affine. Le Conseil national du numérique encourage l’adoption de principes de non-discrimination et la reconnaissance d’un droit à l’explication pour toute personne affectée par une décision issue d’une IA. Les débats parlementaires penchent aussi vers une responsabilisation renforcée des fournisseurs de solutions IA.

- La CNIL intensifie ses contrôles sur la collecte et le traitement des données personnelles.

- De nouveaux recours se dessinent pour les victimes de décisions automatisées contestables.

L’Union européenne envisage, dans la foulée, une harmonisation des pratiques pour stopper la course au pays le moins regardant. La notion de proportionnalité gagne du terrain, cherchant le point d’équilibre entre innovation et protection des droits fondamentaux. Le secteur privé s’empresse de publier des chartes éthiques, mais rien ne garantit que l’éthique tienne la distance face à la cadence effrénée de l’innovation.

Face à ces machines qui défient la loi, le droit se réinvente à grande vitesse. Mais la vraie question demeure : qui, demain, saura encore tracer la limite entre progrès et transgression ?