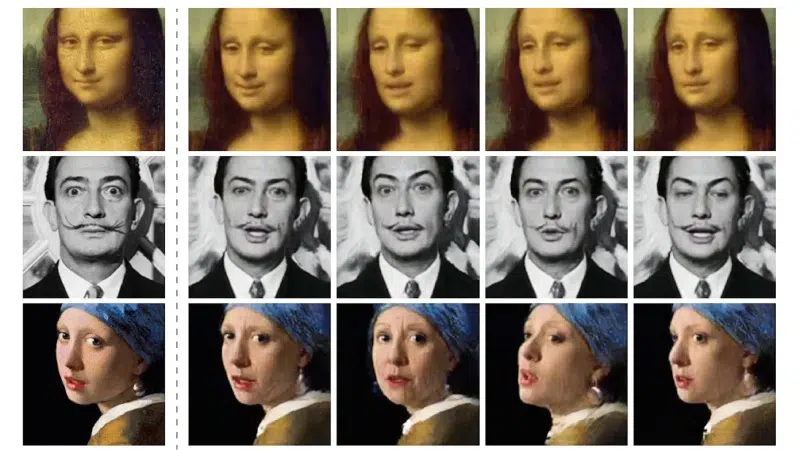

L’écart entre un test concluant et un résultat inutilisable repose souvent sur une variable négligée : la taille de l’échantillon. Une règle fréquemment transgressée consiste à lancer un test B avec un nombre d’utilisateurs insuffisant, compromettant ainsi la validité des conclusions.

Certaines plateformes automatisées vantent des résultats rapides, mais négligent l’importance de la puissance statistique. Une erreur de calcul à ce stade peut entraîner des décisions basées sur des données biaisées, affectant durablement l’expérience utilisateur.

Pourquoi le nombre d’utilisateurs influence la fiabilité d’un test A/B

Derrière chaque démarche d’optimisation de l’expérience utilisateur, la taille de l’échantillon trace la frontière entre analyse sérieuse et simple impression. Lorsqu’un test A/B repose sur un groupe trop réduit, les résultats vacillent : ce que l’on croit être une préférence claire pourrait n’être qu’un tour de passe-passe du hasard. Au contraire, faire appel à un panel large ouvre la voie à des tendances solides et limite l’incertitude dans la prise de décision.

Dépasser la barre des centaines, voire des milliers de participants, ne relève pas d’un excès de zèle. C’est le seul moyen d’obtenir des résultats dignes de confiance. Les mathématiques imposent leur loi : à mesure que l’échantillon grandit, la marge d’erreur diminue, et les pistes d’amélioration deviennent tangibles. Vouloir améliorer un taux de conversion ou repenser un parcours utilisateur sans cette rigueur revient à avancer les yeux bandés.

Les professionnels de l’UX sont unanimes : choisir une taille d’échantillon pertinente, c’est s’assurer que les écarts repérés ne sont ni des caprices statistiques, ni le reflet d’un groupe atypique. Ce qui compte, c’est d’apporter des changements bénéfiques à l’ensemble des utilisateurs, et non de faire plaisir à une poignée d’exceptions.

Pour mieux cerner les enjeux, voici trois points clés à surveiller lors du choix du panel :

- Taille échantillon insuffisante : risque de résultats erronés

- Tests utilisateurs sur un large panel : assurance d’une expérience optimisée

- Résultats statistiquement significatifs : fondement de toute prise de décision éclairée

La diversité des comportements testés offre un miroir fidèle à la complexité de la réalité. Chaque participant, par ses actions et réactions, enrichit la valeur des résultats obtenus. Plus le groupe est vaste et varié, plus le verdict du test s’approche de la vérité terrain.

Combien de participants faut-il vraiment pour un test B pertinent ?

La taille de l’échantillon façonne le niveau de fiabilité d’un test auprès des utilisateurs. Pour des tests de taux de conversion, la plupart des études recommandent de réunir au moins 200 à 400 participants par variante testée. Cette plage permet de tirer des conclusions exploitables et de limiter les distorsions liées à une trop grande variabilité individuelle.

Quand il s’agit de tests d’utilisabilité, la logique diffère. Jakob Nielsen, référence mondiale en ergonomie numérique, souligne souvent qu’avec cinq utilisateurs, la majorité des problèmes majeurs ressortent lors de tests accompagnés. Mais dès que l’on adopte des tests à distance ou des scénarios de premier clic, la diversité des réactions pousse à augmenter ce nombre afin de collecter des retours plus nuancés.

Selon la nature de l’expérimentation, voici les ordres de grandeur à retenir :

- Pour un test utilisateur classique : entre 5 et 10 participants suffisent à révéler les défauts les plus flagrants.

- Pour des tests à grande échelle visant l’optimisation du taux de conversion, tablez sur plusieurs centaines d’utilisateurs.

- Les tests de premier clic ou les études quantitatives s’appuient sur un panel d’au moins 100 à 200 personnes pour éviter les biais d’interprétation.

À chaque contexte, sa méthodologie : tester rapidement un prototype nécessite peu de participants, alors qu’une expérimentation statistique exige un volume bien supérieur. Ajustez le nombre de participants selon le niveau de confiance attendu, l’enjeu du produit et la diversité des personnes visées.

Les critères essentiels pour déterminer la taille idéale de votre échantillon

Choisir la taille d’échantillon ne s’improvise pas. Plusieurs critères entrent en jeu dès qu’il s’agit d’obtenir des résultats robustes, qu’il s’agisse d’analyses qualitatives lors de tests utilisateurs ou d’expérimentations quantitatives centrées sur le taux de conversion. Première variable : le niveau de confiance recherché. Plus il grimpe, plus il faut grossir le panel pour écarter la part de hasard.

Autre paramètre déterminant : la marge d’erreur tolérée. Vouloir la réduire impose d’augmenter le nombre de participants. Un test A/B qui vise à déceler une variation subtile sur un site très fréquenté devra réunir davantage de répondants qu’une refonte totale attendue au tournant. La variabilité des comportements entre utilisateurs compte aussi : plus votre public est hétérogène, plus vous devrez élargir l’éventail des profils testés.

Pour fixer le cap, gardez ces trois leviers en tête :

- Taille de l’effet : plus l’écart à détecter entre les versions est réduit, plus il faut de participants pour obtenir un résultat fiable.

- Outils de test : de nombreux outils d’utilisabilité intègrent des simulateurs pour ajuster la taille de l’échantillon selon vos objectifs.

- Contexte du test : entre tests exploratoires, tests de validation, à distance ou en présence, chaque cas impose son propre seuil de volume.

Pour tirer le meilleur parti de l’expérience utilisateur et disposer de données vraiment exploitables, adaptez la taille d’échantillon à la portée de votre projet et au niveau d’analyse désiré. Le véritable défi : trouver le juste milieu entre la rigueur scientifique et les contraintes opérationnelles.

Intégrer l’A/B testing dans vos projets UX : conseils pour passer à l’action

Le testing A/B s’est imposé comme un passage obligé dans la conception centrée utilisateur. Avancez avec méthode : commencez par une hypothèse concrète, puis choisissez des indicateurs de performance cohérents avec vos ambitions. L’expérience utilisateur ne se limite pas à un simple taux de conversion. L’analyse doit englober la fluidité des parcours, la capacité d’engagement sur des pages clés, ou encore la satisfaction révélée lors de tests d’utilisabilité.

Adaptez le nombre de participants selon l’objectif. Pour des tests utilisateurs exploratoires, quelques profils bien choisis suffisent à dégager les principaux points de friction. Pour des tests quantitatifs qui visent à booster la conversion, il faudra miser sur des centaines d’interactions, selon le trafic de votre site et le niveau de détail souhaité dans l’analyse.

Voici quelques repères pour structurer votre démarche et renforcer la pertinence des tests :

- Outils : privilégiez des plateformes de test complètes, capables de simuler des parcours, de recueillir des feedbacks, et de fournir des rapports précis.

- Itération : préférez des cycles courts et répétés, en ajustant chaque variable pour affiner l’expérience utilisateur à chaque étape.

La collaboration entre designers, analystes et responsables produit donne toute sa valeur au processus. Croisez les chiffres avec les retours de terrain pour mieux comprendre comment les utilisateurs interagissent avec votre service. La discipline dans la collecte et le traitement des données reste la meilleure alliée pour transformer chaque expérimentation en progrès mesurable.

Au bout du compte, tout test B réussi repose sur un équilibre subtil : assez de participants pour capter la réalité, assez d’analyse pour tirer le vrai du faux, et la volonté constante d’ajuster le tir. Dans cette quête, chaque donnée compte, chaque utilisateur pèse. C’est là que se joue la différence entre intuition et certitude.