Déterminer la taille optimale d’un groupe pour un test B ne relève pas d’une simple formule mathématique universelle. Malgré la popularité de certaines règles empiriques, les écarts entre industries et objectifs peuvent faire varier les seuils d’utilisateurs de manière significative.

Certains protocoles préconisent des volumes bien supérieurs à la moyenne pour limiter les biais, tandis que d’autres s’appuient sur des méthodologies plus agiles, privilégiant la rapidité d’exécution à l’exhaustivité statistique. Entre exigences de fiabilité et contraintes de ressources, la mise en œuvre d’un test B efficace nécessite des arbitrages précis.

l’a/b testing et les tests utilisateurs : quelles différences et complémentarités ?

L’a/b testing et les tests utilisateurs poursuivent le même but : rehausser l’expérience utilisateur de votre service numérique. Mais ces deux méthodes n’empruntent ni les mêmes chemins, ni les mêmes outils, et leur combinaison s’avère redoutable pour affiner une interface ou repenser un parcours.

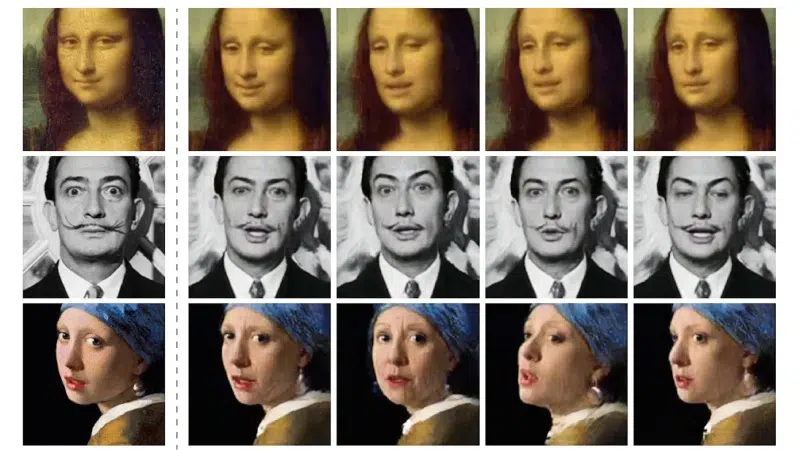

Le principe de l’a/b testing ? Soumettre deux variantes d’une page à un large échantillon et mesurer, chiffres à l’appui, laquelle remporte la mise en termes de conversion ou d’engagement. Cette approche quantitative impose un volume d’utilisateurs conséquent pour que les résultats tiennent la route statistiquement. Les équipes s’en servent pour trancher des points précis : bouton d’achat, wording d’un call-to-action, position d’un formulaire.

À l’opposé, le test utilisateur s’appuie sur l’exploration qualitative. Quelques participants, rarement plus d’une dizaine, testent votre produit sous l’œil attentif des observateurs. On relève chaque réaction, on écoute les remarques, on repère les zones d’incompréhension souvent invisibles dans les stats. Ici, il s’agit de comprendre en profondeur les vrais obstacles, d’anticiper les attentes et d’identifier les détails qui échappent aux grands nombres.

Voici ce que chaque approche permet d’éclairer :

- L’a/b testing tranche : « Quelle version performe le plus ? »

- Le test utilisateur révèle : « Quelles raisons se cachent derrière un comportement ou un blocage ? »

En associant ces deux méthodes, vous croisez la puissance des chiffres avec la finesse de l’observation. Les tests multivariés élargissent le champ : ils testent plusieurs variables simultanément, pour aller encore plus loin dans l’optimisation. À la clé : des décisions plus sûres, des arbitrages plus justes, et une expérience utilisateur réellement améliorée, car alimentée par la force du quantitatif et la profondeur du qualitatif.

combien d’utilisateurs faut-il vraiment pour un test b réussi ?

Le débat sur le nombre d’utilisateurs pour un test B anime toutes les discussions sérieuses autour de l’expérience utilisateur. On ne s’improvise pas statisticien : la taille de l’échantillon se décide avec méthode, et non à la louche. Pour viser des résultats fiables, il faut tenir compte des objectifs, du trafic disponible et de l’impact recherché.

La méthode ? On ajuste la taille du panel selon la durée prévue du test, le taux de conversion habituel et la différence minimale que l’on souhaite détecter. Trop peu de participants : les résultats sont brouillés, difficilement exploitables. Trop : perte de temps et d’énergie pour une amélioration marginale. Les calculateurs de taille d’échantillon en ligne se révèlent précieux pour affiner rapidement le bon volume.

Pour clarifier, voici comment adapter la taille de votre panel selon votre contexte :

- Sur un site à fort trafic, il faut souvent tabler sur plusieurs milliers d’utilisateurs.

- Pour une audience plus restreinte, il est sage de revoir les ambitions à la baisse et d’allonger la période de test.

Un point déterminant : la qualité du panel prévaut autant que son ampleur. Segmentez vos participants en fonction des profils cibles : c’est la seule manière d’obtenir des résultats qui reflètent réellement les usages sur votre produit. Les chiffres ne suffisent pas, seule la justesse de la sélection garantit la pertinence des enseignements.

erreurs courantes à éviter lors du recrutement et de la mise en place

Constituer un panel d’utilisateurs pour mener des tests utilisateurs ne se résume pas à remplir une colonne sur un tableur. La facilité de recruter en vitesse, au détriment de la diversité, guette chaque chef de projet. Un groupe trop homogène, et vous passez à côté de comportements inattendus, de besoins spécifiques, de retours précieux pour l’accessibilité. Il est impératif de viser un échantillon fidèle à la réalité de vos utilisateurs, ceux qui feront vivre, ou non, votre interface.

Un autre travers fréquent : laisser des zones d’ombre dans les scénarios de test. Consignes floues, parcours mal définis : ce flou engendre des données impossibles à interpréter. Chaque étape du test utilisateur doit être pensée en détail : de la sélection des profils à la restitution, sans oublier les contraintes techniques (compatibilité sur tous supports, accessibilité, etc.).

Pour sécuriser l’organisation et l’analyse, gardez en tête ces points de vigilance :

- Mal évaluer le temps nécessaire pour orchestrer le test revient à perdre en rigueur et à fragiliser la démarche.

- Ne recruter que des profils déjà familiers de votre produit fausse la réalité de l’expérience vécue par un nouvel utilisateur.

- Laisser les participants sans point de contact technique, c’est risquer des interruptions non remontées et des retours inexploitables.

La préparation d’un test d’utilisabilité exige anticipation, méthode et ouverture à la diversité. Ce sont ces ingrédients qui assurent la qualité du recrutement, la clarté des étapes et la fiabilité des enseignements tirés du terrain.

des conseils concrets pour maximiser la valeur de vos tests et booster l’expérience utilisateur

Pour tirer un réel bénéfice de votre étude, commencez par structurer le test utilisateur. Déterminez les objectifs, ciblez le parcours à observer, sélectionnez les méthodes adaptées : observation directe, entretiens semi-directifs, questionnaires ou enquêtes. Jouer sur la complémentarité de ces approches permet de révéler les irritants cachés, que ce soit sur l’interface digitale, un parcours utilisateur spécifique ou la page qui décide de la conversion.

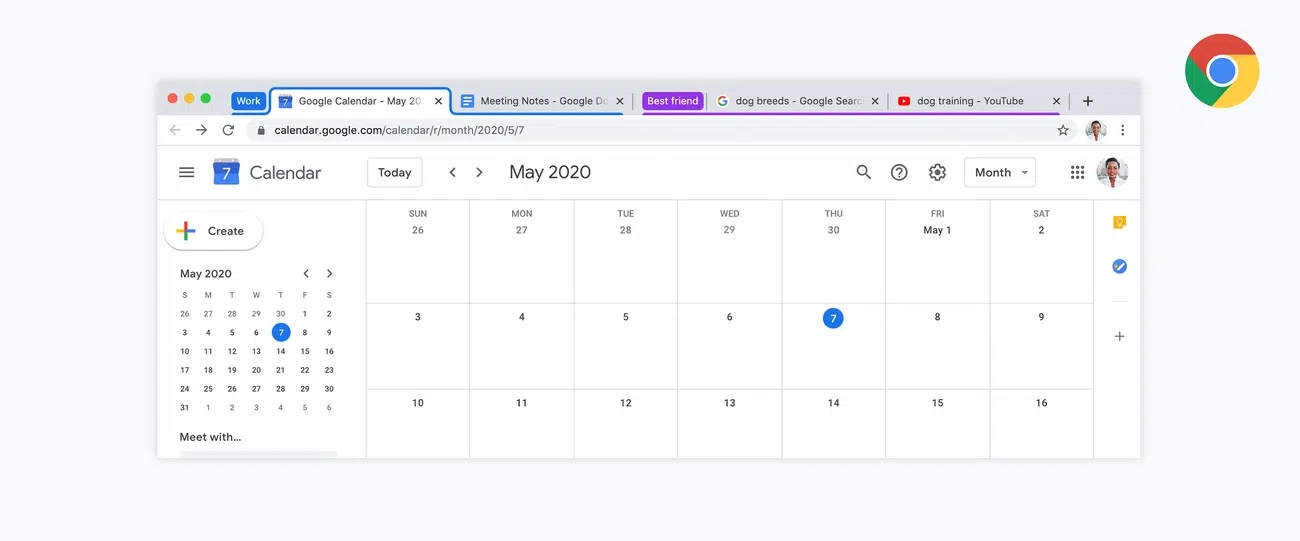

Les outils de test comme Maze, Lookback, Hotjar ou Optimal Workshop donnent accès à des informations bien plus précises. L’eye-tracking permet d’identifier les zones qui captent l’attention ; l’enregistrement vidéo (tl;dv, Lookback) aide à analyser les comportements à tête reposée. L’intégration de l’intelligence artificielle facilite la synthèse des retours et la détection des tendances de fond. Le rapport d’analyse, lui, doit être structuré : mettez en avant les freins à la conversion et proposez des axes d’amélioration concrets.

Pour renforcer l’efficacité de votre démarche, voici quelques leviers à activer :

- Recoupez les observations qualitatives avec des indicateurs mesurables : taux de clics, taux d’abandon, temps passé sur chaque page.

- Multipliez les tests sur le temps : l’amélioration continue repose sur des cycles courts et réguliers.

- Maintenez un panel de référence pour suivre l’évolution de l’expérience utilisateur sur vos supports numériques.

Un test utilisateur bien mené, c’est la garantie de ne plus passer à côté des détails qui font toute la différence sur un produit. La capacité à identifier et corriger rapidement les points de friction ouvre la voie à des taux de conversion en hausse, et à des utilisateurs qui restent, reviennent et recommandent.